ภูมิทัศน์โซเชียลมีเดียในประเทศไทยมีลักษณะเด่นคือการใช้งานที่แพร่หลายของแพลตฟอร์มหลัก โดย Facebook และ LINE ยังคงเป็นแพลตฟอร์มที่มีบทบาทสำคัญในการสื่อสารและการเข้าถึงข้อมูล โดยมีอัตราการใช้งานประจำทุกเดือนสูงเกือบ 90% ในขณะเดียวกัน TikTok ได้กลายเป็นแพลตฟอร์มที่เติบโตอย่างก้าวกระโดด ด้วยจำนวนผู้ใช้งานมากกว่า 85% ซึ่งเป็นข้อพิสูจน์ถึงความนิยมอย่างสูงในการเปิดรับเนื้อหารูปแบบวิดีโอสั้น (Short Video) ของคนไทย สิ่งที่น่าสนใจคือ เบื้องหลังการทำงานของแพลตฟอร์มเหล่านี้ในปัจจุบันพึ่งพาเทคโนโลยีปัญญาประดิษฐ์ (Artificial Intelligence) หรือ “AI” มากขึ้นเรื่อย ๆ จนกลายเป็นส่วนหนึ่งของชีวิตเราโดยไม่ทันรู้ตัว1

ปัญญาประดิษฐ์ หรือ AI เข้ามามีบทบาทในการดำเนินชีวิตประจำวันของเรา ไม่ว่าจะเป็น เรื่องสุขภาพ การเรียนรู้ การเดินทาง การเงิน หรือแม้แต่ด้านความมั่นคงและวัฒนธรรม เทคโนโลยีนี้เคยถูกมองว่าเป็นเรื่องในนิยายวิทยาศาสตร์ แต่วันนี้กลับกลายเป็นส่วนหนึ่งที่แทบขาดไม่ได้ของสังคมสมัยใหม่ ด้วยความสามารถในการประมวลผลข้อมูลมหาศาล AI ไม่เพียงช่วยให้การทำงานมีประสิทธิภาพขึ้น แต่ยังเข้ามาเปลี่ยนวิธีการดำเนินชีวิตประจำวัน ตั้งแต่การใช้บริการออนไลน์ไปจนถึงการตัดสินใจในเรื่องสำคัญของชีวิต2

อย่างไรก็ตาม การเปลี่ยนแปลงที่รวดเร็วเช่นนี้ก็มาพร้อมกับความท้าทาย โดยเฉพาะสำหรับผู้สูงอายุ ที่อาจไม่คุ้นเคยกับเทคโนโลยีและสื่อดิจิทัลสมัยใหม่ การเผชิญกับวิดีโอปลอมหรือข้อมูลที่ถูกบิดเบือนบนโซเชียลมีเดียจึงเป็นความเสี่ยงที่อาจนำไปสู่ความเชื่อผิด ๆ ความวิตกกังวล หรือการตัดสินใจที่อันตรายได้

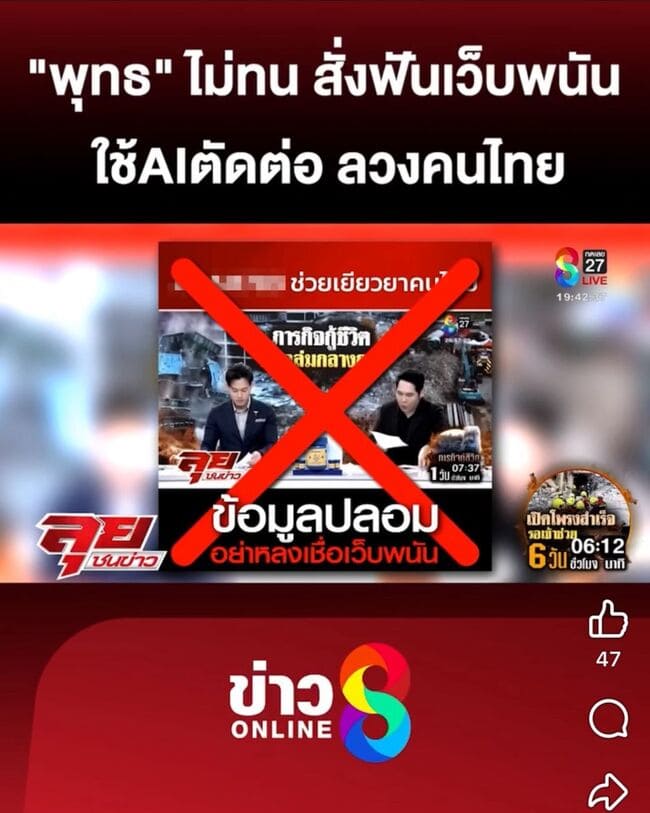

ยกตัวอย่าง ล่าสุดมีเรื่องเตือนภัยจากผู้ประกาศข่าวชื่อดัง พุทธ อภิวรรณ และ จิตดี ศรีดี จากรายการ ลุยชนข่าว ช่อง 8 ในเครือ อาร์เอส กรุ๊ป ออกโรงเตือนประชาชน หลังพบว่ามีมิจฉาชีพนำคลิปจากรายการ ไปตัดต่อและแต่งเสียงด้วย AI โดยใช้เสียงของ พุทธ อภิวรรณ และ ไอซ์ สารวัตร เพื่อหลอกลวงประชาชน ให้กดลิงก์เว็บพนันออนไลน์ กลโกงดังกล่าวใช้วิธีดัดแปลงเสียงจากข่าวอื่น ให้ฟังดูเหมือนเป็นการเชิญชวนช่วยเหลือผู้ประสบภัย แต่แท้จริงแล้วกลับเป็นการชักจูงให้หลงเชื่อและกดลิงก์ไปยังแพลตฟอร์มผิดกฎหมาย ซึ่งเสี่ยงต่อการถูกดูดเงินหรือข้อมูลส่วนตัว พุทธ อภิวรรณ ย้ำเตือนกลางรายการว่า3

“ฝากถึงญาติผู้ใหญ่ และผู้สูงอายุทุกท่าน อย่าหลงเชื่อกลโกงนี้เด็ดขาด เพราะเป็นข่าวปลอม หากกดลิงก์อาจเสี่ยงสูญเสียเงิน ทางฝ่ายกฎหมายของช่อง 8 พร้อมดำเนินการขั้นสูงสุดกับผู้กระทำความผิด”3

ภาพ: https://www.naewna.com/entertain/875311

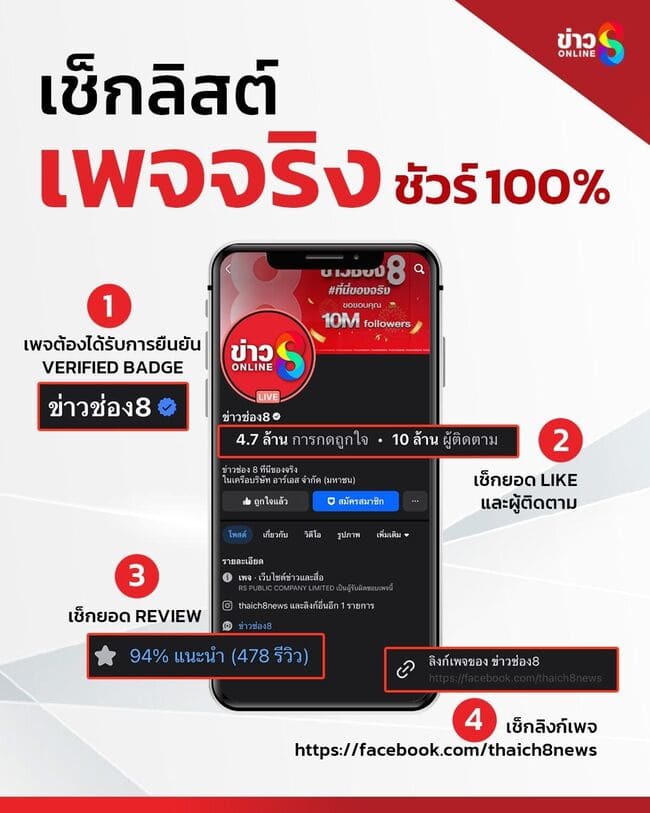

เพื่อป้องกันการสับสนและไม่ให้ประชาชนตกเป็นเหยื่อ ให้สังเกต รูปแบบของชิ้นงานเพจข่าวออนไลน์ ของช่อง 8 ซึ่งขณะนี้ มีการปรับดีไซน์เป็นโลโก้ช่อง 8 แบบใหม่ และที่สำคัญ ให้สังเกตเครื่องหมายการตรวจสอบยืนยันเพจเฟซบุ๊ก (Verified Badge) โดยต้องมีเครื่องหมายสีฟ้าด้านหลังโปรไฟล์เพจ “ข่าวช่อง 8” และมียอดผู้ติดตามจำนวน 10 ล้านคนเท่านั้น สำหรับคลิปที่ถูกตัดต่อและนำไปเผยแพร่ พบว่ามีการโพสต์บนเพจ “นอท ขอช่วยเหลือคนไทย” (เพจปลอม ซึ่งปัจจุบันถูกลบไปแล้ว) อย่างไรก็ตาม ขอให้ประชาชน ใช้วิจารณญาณในการเสพข้อมูล และหลีกเลี่ยงการแชร์คลิปที่อาจเป็นเครื่องมือของมิจฉาชีพ3

ภาพ: https://www.naewna.com/entertain/875311

เหตุการณ์เตือนภัยจากรายการ “ลุยชนข่าว” เป็นตัวอย่างที่เป็นรูปธรรมและน่ากังวลอย่างยิ่ง สะท้อนให้เห็นว่าภัยจาก AI ไม่ใช่เรื่องไกลตัวอีกต่อไป แต่ได้แทรกซึมเข้ามาในชีวิตประจำวันผ่านสื่อที่ผู้คนคุ้นเคย การที่มิจฉาชีพสามารถปลอมแปลงเสียงของผู้ประกาศข่าวที่น่าเชื่อถือได้ถึงขนาดนี้ ยิ่งตอกย้ำว่าการรับสื่อ โดยปราศจากการตรวจสอบอย่างถี่ถ้วนนั้นมีความเสี่ยงสูง

ภาพ: https://www.naewna.com/entertain/875311

ดังนั้น การสร้างทักษะพื้นฐานอย่าง “การสังเกตและการตั้งคำถาม” จึงเป็นสิ่งสำคัญ เพราะนี่จะเป็นจุดเริ่มต้นที่ช่วยให้ผู้สูงอายุสามารถสังเกตวิดีโอที่สร้างด้วย AI และแยกแยะความจริงจากสิ่งที่ปลอมปนได้

เพื่อให้การสังเกตของเราทำได้ง่ายขึ้น มี “คู่มือ” สำหรับดูว่าวิดีโอนั้นเป็นของจริงหรือของปลอม ผู้สูงอายุควรทราบถึงจุดบกพร่องที่มักปรากฏในงานของ AI โดยมีข้อสังเกตวิดีโอที่ใช้ AI สร้างขึ้นมา 4 ด้าน

- ความผิดปกติบนใบหน้าและร่างกาย วิดีโอที่สร้างจาก AI โดยเฉพาะเทคโนโลยี Deepfake มักจะเน้นการเปลี่ยนแปลงที่ใบหน้าเป็นหลัก ทำให้เกิดข้อผิดพลาดเล็ก ๆ น้อย ๆ ที่สามารถสังเกตได้4, 5

- ดวงตาและการกะพริบตา: AI รุ่นเก่ามักสร้างการกะพริบตาที่ไม่เป็นธรรมชาติ เช่น ไม่กะพริบตาเลย หรือกะพริบตาน้อยเกินไปอย่างผิดปกติ นอกจากนี้ การสะท้อนของแสงในดวงตาอาจดูผิดเพี้ยนหรือไม่สอดคล้องกับสภาพแวดล้อม

- ผิวหนังและเส้นผม: ผิวหนังของบุคคลในวิดีโออาจดูเรียบเนียนหรือเบลอเกินจริงราวกับใส่ฟิลเตอร์ตลอดเวลา ในทางกลับกัน อาจมีส่วนที่ดูเหี่ยวย่นผิดปกติและไม่เข้ากับส่วนอื่นของใบหน้า เส้นผมหรือขนบนใบหน้าอาจดูไม่เป็นธรรมชาติ มีลักษณะเหมือนถูกแปะทับลงไป และอาจมีบางส่วนที่เบลอหรือผิดเพี้ยนเมื่อมีการเคลื่อนไหว

- ริมฝีปากและการพูด: การขยับริมฝีปากอาจไม่สอดคล้องกับเสียงพูด (Poor Lip-Syncing) อย่างสมบูรณ์แบบ รูปแบบการขยับอาจดูแข็งทื่อและไม่เป็นธรรมชาติ

- ฟันและภายในปาก: AI อาจประสบปัญหาในการสร้างรายละเอียดของฟันแต่ละซี่ ทำให้ฟันดูเป็นแผงเดียวกัน หรือมีรูปร่างที่ไม่ชัดเจน

- ความไม่สมส่วนและรูปร่างที่ผิดเพี้ยน: ให้สังเกตรายละเอียดเล็ก ๆ น้อย ๆ เช่น ใบหูทั้งสองข้างมีรูปร่างต่างกันอย่างชัดเจน หรือนิ้วมือที่อาจมีจำนวนผิดปกติ บิดเบี้ยว หรือมีความยาวผิดสัดส่วน ซึ่งเป็นจุดที่โมเดล AI มักทำพลาด

ภาพ: https://cmsw.mit.edu/angles/2023/deepfakes-generation-and-detection/

- สิ่งแปลกปลอมและสภาพแวดล้อม ความผิดพลาดไม่ได้จำกัดอยู่แค่ตัวบุคคล แต่ยังรวมถึงสภาพแวดล้อมและคุณภาพของวิดีโอโดยรวม6, 7

- การบิดเบี้ยวรอบวัตถุ: สังเกตบริเวณขอบของใบหน้าหรือร่างกายของบุคคล อาจมีการบิดเบี้ยว (Warping) หรือความเบลอที่ผิดปกติเกิดขึ้นกับพื้นหลัง โดยเฉพาะเมื่อมีการเคลื่อนไหว

- แสงและเงาที่ไม่สอดคล้องกัน: แสงที่ตกกระทบบนใบหน้าอาจไม่ตรงกับแหล่งกำเนิดแสงในวิดีโอ หรือเงาอาจทอดไปในทิศทางที่ไม่ถูกต้องตามหลักฟิสิกส์ ซึ่งเป็นจุดที่ AI มักจะคำนวณพลาด

- คุณภาพวิดีโอที่ผิดปกติ: บางครั้งผู้สร้าง Deepfake อาจจงใจลดคุณภาพของวิดีโอให้ต่ำลง เพื่อปกปิดร่องรอยความผิดปกติ หากพบว่าวิดีโอมีความละเอียดต่ำหรือมีการกระตุก (Glitches) เป็นบางช่วง อาจเป็นสัญญาณเตือนได้

- การเคลื่อนไหวและพฤติกรรม

- การเคลื่อนไหวที่แข็งทื่อ: การเคลื่อนไหวของร่างกายหรือการหันศีรษะอาจดูไม่ลื่นไหลและเป็นธรรมชาติ มีลักษณะคล้ายหุ่นยนต์หรือดูแข็งกระด้าง8

- ตำแหน่งศีรษะและลำตัว: มุมของศีรษะอาจดูผิดเพี้ยนเมื่อเทียบกับตำแหน่งของลำตัว ซึ่งเป็นผลมาจากการนำใบหน้าของคนหนึ่งไปวางทับบนร่างกายของอีกคนหนึ่ง8

- เสียง

- เสียงพูดที่ไร้อารมณ์: เสียงที่สังเคราะห์โดย AI อาจมีลักษณะราบเรียบ (Monotonous) ขาดน้ำเสียงสูงต่ำ และอารมณ์ความรู้สึกที่เป็นธรรมชาติของมนุษย์9

- เสียงรบกวนที่ผิดปกติ: อาจมีเสียงแปลกปลอมแทรกเข้ามา หรือในทางกลับกัน วิดีโออาจเงียบผิดปกติเพราะไม่มีเสียงรบกวนรอบข้าง (Ambient Noise) เลย9

การสังเกตรายละเอียดเล็ก ๆ ในวิดีโอ ไม่ว่าจะเป็นใบหน้า การเคลื่อนไหว เสียง หรือสิ่งรอบตัว จะช่วยให้ผู้สูงอายุแยกแยะวิดีโอจริงจากวิดีโอที่เป็น AI ได้ง่ายขึ้น อย่ารีบเชื่อหรือแชร์ข้อมูลทันที ลองใช้สายตา และสติ ในการสังเกตก่อน การฝึกสังเกตแบบนี้ไม่เพียงปกป้องตัวเอง แต่ยังช่วยให้แชร์สิ่งที่ถูกต้องกับครอบครัวและเพื่อน ๆ อย่างปลอดภัย เริ่มสังเกตตั้งแต่วันนี้ ก็สามารถใช้โซเชียลมีเดียได้อย่างมั่นใจและปลอดภัย

เขียนโดย

ลัดดาวัลย์ ฉิมงาม

รายการอ้างอิง

- ปรีดี นุกุลสมปรารถนา. (2568). รวมสถิติ Digial และการใช้ Social Media ในไทยประจำปี 2025. สืบค้นเมื่อ 24 กันยายน 2568 จาก https://www.popticles.com/trends/thailand-digital-and-social-media-2025/

- Zhao Hong-Guang, Li Xin-Zhu, VIAFID ORCID, Kang Xin. (2024). Development of an artificial intelligence curriculum design for children in Taiwan and its impact on learning outcomes. Palgrave Macmillan, (1339). https://doi.org/10.1057/s41599-024-03839-z

- แนวหน้า. (2568). ‘พุทธ อภิวรรณ’เตือนภัย!’มิจฉาชีพแอบอ้าง’ลุยชนข่าว’ โปรโมตเว็บพนัน. สืบค้นเมื่อ 28 กันยายน 2568 จาก https://www.naewna.com/entertain/875311

- MIT Media Lab. (2025). Detect DeepFakes: How to counteract misinformation created by AI was active from April 2020 to January 2025. สืบค้นเมื่อ 25 กันยายน 2568 จาก https://www.media.mit.edu/projects/detect-fakes/overview/

- Abdul Qadir, Rabbia Mahum, Mohammed A El-Meligy, Adham E Ragab, Abdulmalik AlSalman, Muhammad Awais. (2024). An efficient deepfake video detection using robust deep learning. Heliyon, 10(5). https://doi.org/10.1016/j.heliyon.2024.e25757

- Bernadette Young. (2024). Turns Out, I’m Not Real: Detecting AI-Generated Videos. สืบค้นเมื่อ 25 กันยายน 2568 จาก https://www.engineering.columbia.edu/about/news/turns-out-im-not-real-detecting-ai-generated-videos

- eSafety Commissioner (Australian Government). (2025). Deepfake trends and challenges. สืบค้นเมื่อ 25 กันยายน 2568 จาก https://www.esafety.gov.au/industry/tech-trends-and-challenges/deepfakes

- ALTV by Thai PBS. (2567). จับโป๊ะ Deepfake ด้วย 5 เทคนิคจับจุดสังเกตวิดีโอปลอม. สืบค้นเมื่อ 25 กันยายน 2568 จาก https://altv.thaipbs.or.th/content/altv-news/66e7a6a06df88fb47ff33b3f

- European Digital Media Observatory (EDMO). (2024). TIPS FOR USERS TO DETECT AI-GENERATED CONTENT. สืบค้นเมื่อ 25 กันยายน 2568 https://edmo.eu/publications/tips-for-users-to-detect-ai-generated-content/